近期DeepSeek熱度很高,為方便儀表工了解和使用DeepSeek,本文將DeepSeek操作指導手冊分享給大家。

第一章:準備篇(30分鐘上手)

第?章:基礎對話篇(像交朋友?樣學交流)

2.1 有效提問的五個??法則

法則?:明確需求

◆?錯誤?例:「幫我寫點東西」

◆?正確姿勢:「我需要?封求職郵件,應聘新媒體運營崗位,強調(diào)3年公眾號運營經(jīng)驗」

法則?:提供背景

◆?錯誤?例:「分析這個數(shù)據(jù)」

◆?正確姿勢:「這是×××過去三個?的銷售數(shù)據(jù),請分析周末和?作?的銷量差異(附CSV數(shù)據(jù))」

法則三:指定格式

◆?錯誤?例:「給?個營銷?案」

◆?正確姿勢:「請?表格形式列出三種×××產(chǎn)品促銷?案,包含成本預估和預期效果」

法則四:控制?度

◆?錯誤?例:「詳細說明」

◆?正確姿勢:「請?200字以內(nèi)解釋區(qū)塊鏈技術,讓完全不懂技術的??能聽懂」

法則五:及時糾正

◆當回答不滿意時,可以:

「這個?案成本太?,請?zhí)峁╊A算控制在500元以內(nèi)的版本」

「請?更正式的語?重寫第?段」

2.2 新?必學的10個魔法指令

基礎指令集:

①續(xù)寫 :當回答中斷時?動繼續(xù)?成

②簡化 :將復雜內(nèi)容轉換成??話

③?例 :要求展?實際案例(特別是寫代碼時)

④步驟 :讓AI分步驟指導操作流程

⑤檢查 :幫你發(fā)現(xiàn)?檔中的錯誤

2.3 10個使用技巧教

昌暉儀表用10個使用技巧教會大家如何與DeepSeek高質量對話,以及一些隱藏技巧。

2.3.1 選對模式,事半功倍

DeepSeek提供基礎模型(V3)、深度思考(R1)和聯(lián)網(wǎng)搜索三種模式,針對不同場景靈活選擇:

2.3.1.1 基礎模型(V3)

①定位:快速響應的百科助手

②特點:默認模式,無需勾選功能支持日常問答、文本生成等基礎任務(如“解釋量子力學”)響應速度極快(平均1秒內(nèi))

③適用場景:日常問答首選,響應快,適合百科查詢、簡單任務

2.3.1.2 深度思考(R1)

①定位:邏輯推理專家

②特點:專攻復雜問題(數(shù)學證明、代碼調(diào)試、學術分析)支持思維鏈展示,推理過程全透明響應較慢(復雜問題需2-3分鐘)

③適用場景:專攻復雜推理,如數(shù)學題、代碼調(diào)試(如“用Python實現(xiàn)快速排序”)

2.3.1.3 聯(lián)網(wǎng)搜索

①定位:實時信息捕手

②特點:基于RAG技術整合網(wǎng)絡最新數(shù)據(jù)(知識庫更新至2024年7月)支持查詢動態(tài)事件(如“2025春晚《秧bot》技術解析”)

③使用技巧:避免與R1模式同時啟用,以防邏輯沖突

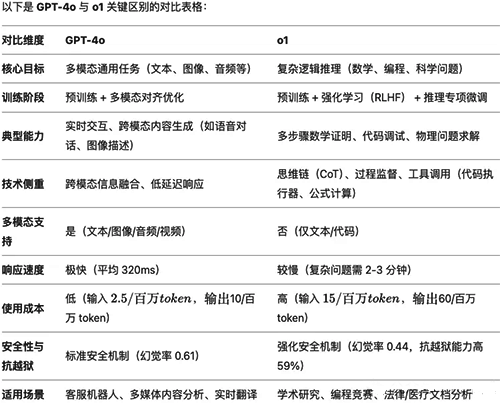

2.3.2 性能對標:與主流模型的橫向對比

2.3.2.1 V3對標GPT-4o

DeepSeek的V3模型堪比GPT-4o,二者的設計理念和應用場景非常相似。

V3采用了Moe架構,擁有671B的參數(shù)量,能夠在百科知識領域提供快速響應。

2.3.2.2 R1對標o1

R1是DeepSeek的深度推理模型,和OpenAI的o1模型非常類似。二者都在處理推理、深度思考以及復雜邏輯問題時,展現(xiàn)出了非凡的能力。

R1采用了660B的參數(shù),并且在強化學習和后訓練方面表現(xiàn)出色。

R1更擅長邏輯推理和復雜問題的解答,在這一點上,R1已經(jīng)超越了o1模型。

關于4o與o1的區(qū)別,下面有一張表,大家看完就知道該如何選用V3和R1模型了。

2.3.3 知識更新至2024年7月

目前,DeepSeek的預訓練數(shù)據(jù)(你可以理解為模型已學習的知識),已經(jīng)更新至2024年7月。但對于之后的新聞或技術動態(tài),DeepSeek的聯(lián)網(wǎng)搜索模式就顯得尤為重要,它能夠根據(jù)網(wǎng)絡實時獲取最新信息,彌補知識庫的空白。所以,2024年7月前的問題基本上不需要打開聯(lián)網(wǎng)功能。而之后的問題(比如2025年諾貝爾獎得主是誰?春晚秧Bot),DeepSeekZ目前并未學習,建議開啟聯(lián)網(wǎng)功能,效果更佳。

2.3.4 提示詞核心:準確表達

DeepSeek,無論是V3還是R1模型,都是不太吃提示詞的,只需要做到【準確表達】即可。

通用提示詞模板=身份+目標

適當情況下,也可以補充一些背景信息:通用提示詞模板=身份+背景+目標

還可以是:通用提示詞模板=身份+背景+目標+限制條件

不管哪個模板,其核心都是【準確表達】。能夠做到準確表達,說人話,就已經(jīng)完全夠用了。所以,過去你們學的那些結構化提示詞,從現(xiàn)在起,就可以大膽地丟掉了。

2.3.5 與DeepSeek溝通,盡量說人話

最好的提示詞,就是沒有提示詞,說人話就可以,在會動腦子的deepseek面前,不用玩心思,真誠才是必殺技。越是直白、俗氣,就越能激發(fā)它的潛能。

2.3.6 如何去除DeepSeek的AI味

過去,我們經(jīng)常吐槽AI生成的東西帶有明顯的"AI味"。其根源就在于模型過分追求結構化輸出,習慣性地運用"首先、其次、然后、總而言之"等規(guī)范性的銜接詞,使得內(nèi)容顯得過于程式化和刻板。而作為具有強烈感性特征的生物體,人類對這種理性至上的文字形式實在難以忍受,尤其是當文字呈現(xiàn)出八股文式的呆板架構或學術文體的生硬風格時,更是令人昏昏欲睡。那么這種情況,建議你加一句提示,就可以極大地去除DeepSeek的AI味了。

2.3.7 活用聯(lián)網(wǎng)搜索

以o1為代表的推理模型,基本上都是不能聯(lián)網(wǎng)的。而聯(lián)網(wǎng)搜索是DeepSeek的一大亮點,它讓模型在回答時不僅僅依賴預訓練數(shù)據(jù),還能實時從網(wǎng)絡上檢索最新的信息。你可以問到2024年7月以后發(fā)生的事件,或者某些新興技術領域的問題,DeepSeek都能通過聯(lián)網(wǎng)搜索為你提供更準確、及時的回答。而DeepSeek,是少有的支持推理+聯(lián)網(wǎng)的模型。

2.3.8 活用上傳附件

除了聯(lián)網(wǎng)搜索,DeepSeek還支持上傳附件功能,這為用戶提供了更多個性化的體驗。通過上傳附件,你可以將自己的私密資料、知識庫、甚至是一些需要深度推理的材料直接交給DeepSeek,讓它基于這些專有的文件進行分析和推理。DeepSeek的推理模型,不僅能聯(lián)網(wǎng),還支持上傳附件(最多不超過50個,每個不超過100MB)。推理+上傳附件,可以做更多本地化、私密化的東西,比如你自己的知識庫或者內(nèi)部資料。讓其基于自有知識庫進行推理和思考。

2.3.9 通過持續(xù)追問,獲取詳細答案

運用持續(xù)追問的技巧,能夠幫你快速搞清楚一個復雜問題,大致步驟如下:

①初始提問:"如何做好短視頻腳本?"

②細化追問:"如何在前3秒吸引觀眾?"

③案例擴展:"舉一個儀器儀表賬號的開頭案例"

2.3.10 R1模型的三個開放特性

對于深度思考(R1)模型,DeepSeek做到了三個重要的開放特性,讓R1不僅僅是一個“黑盒”模型,它的思維過程、訓練技術和模型參數(shù)都是透明開放的。

2.3.10.1 思維鏈全開放

R1的思維鏈是完全開放的,用戶可以看到模型進行推理時的每一步邏輯。這不僅是一個回答,而是一個完整的思考過程。通過這種方式,用戶能獲得最終答案,還能夠理解AI是如何得出這個結論的。

2.3.10.2 訓練技術全部公開

DeepSeek采用了RL(強化學習)技術,通過極少的標注數(shù)據(jù)提高了推理能力。所有的訓練技術,包括模型的后訓練過程和數(shù)據(jù)增強方法,都是公開的。這讓廣大網(wǎng)友都能深入理解模型的訓練過程,并且可以根據(jù)需要進行調(diào)整和優(yōu)化。

2.3.10.3 開源模型

DeepSeek還將R1的部分模型進行開源。雖然R1模型本身的參數(shù)高達660B,僅為GPT-4o的1/6(輸入$0.25/百萬token)通常只有大公司才能使用,但DeepSeek也為社區(qū)提供了更小的開源模型,讓更多的開發(fā)者和研究者可以使用。最小的模型只有1.5B參數(shù),適合個人開發(fā)者進行實驗和開發(fā)。

2.4 避坑提醒

①別同時開“深度思考+聯(lián)網(wǎng)”,易卡頓。

②復雜問題用R1,簡單問題用V3,省時高效。